生成式人工智能 (gen ai) 正在凭借其创造力、解决问题和自动化的潜力重塑行业。然而,由于 api 和配置分散,开发人员在集成来自不同提供商的大型语言模型 (llm) 时经常面临重大挑战。互操作性的缺乏使工作流程变得复杂,延长了开发时间,并阻碍了有效的 gen ai 应用程序的创建。

为了解决这个问题,andrew ng 的团队推出了 aisuite,这是一个开源 python 库,可以简化 openai、anthropic 和 ollama 等提供商之间的法学硕士集成。 aisuite 使开发人员能够使用简单的“provider:model”字符串(例如 openai:gpt-4o 或 anthropic:claude-3-5)在模型之间切换,从而无需大量重写代码。通过提供统一的接口,aisuite 显着降低了复杂性,加速了开发,并为构建多功能 gen ai 应用程序开辟了新的可能性。

在本文中,我们将探讨 aisuite 的工作原理、实际应用以及它在解决与不同法学硕士合作的挑战方面的有效性。

入门 目录- 什么是aisuite

- 为什么aisuite很重要

- 使用 aisuite 进行实验

- 创建聊天完成

- 创建通用查询函数

aisuite 是由 andrew ng 团队开发的开源 python 库,用于简化来自多个提供商的大型语言模型 (llm) 的集成和管理。它抽象化了使用不同 api、配置和数据格式的复杂性,为开发人员提供了一个统一的框架来简化他们的工作流程。

aisuite的主要特点:- 简单的界面:aisuite 提供了一个简单且一致的界面来管理各种 llm。开发者只需几行代码即可将模型集成到他们的应用程序中,大大降低了 gen ai 项目的进入门槛。

- 统一框架:通过抽象多个api之间的差异,aisuite无缝处理不同类型的请求和响应。这减少了开发开销并加速了原型设计和部署。

- 轻松模型切换:使用aisuite,模型之间的切换就像更改代码中的单个字符串一样简单。例如,开发人员可以指定“provider:model”组合,如 openai:gpt-4o 或 anthropic:claude-3-5,而无需重写应用程序的重要部分。

- 可扩展性:aisuite 旨在适应不断发展的 gen ai 环境。开发人员可以在新模型和提供程序可用时添加它们,确保应用程序保持最新的人工智能功能。

aisuite 解决了 gen ai 生态系统中的一个关键痛点:不同提供商的法学硕士之间缺乏互操作性。通过提供统一的接口,它简化了开发过程,节省了时间并降低了成本。这种灵活性允许团队通过为特定任务选择最佳模型来优化性能。

早期基准测试和社区反馈凸显了 aisuite 减少多模型应用程序集成时间、提高开发人员效率和生产力的能力。随着 gen ai 生态系统的发展,aisuite 降低了实验、构建和扩展人工智能驱动的解决方案的障碍。

尝试 aisuite让我们通过安装必要的依赖项开始探索 aisuite。

安装依赖项- 通过执行以下命令创建并激活虚拟环境。

python -m venv venv source venv/bin/activate #for ubuntu venv/scripts/activate #for windows

- 使用 pip 安装 aisuite、openai 和 python-dotenv 库。

pip install aisuite[all] openai python-dotenv

创建一个名为 .env 的文件。该文件将存储您的环境变量,包括 openai 密钥。

- 打开 .env 文件并添加以下代码来指定您的 openai api 密钥:

openai_api_key=sk-proj-7xypjkdag_gdl0_... groq_api_key=gsk_8nigj24k2p0j5rwrwoobw...

- 将 api 密钥添加到环境变量中。

import os

from dotenv import load_dotenv

load_dotenv()

os.environ['openai_api_key'] = os.getenv('openai_api_key')

os.environ['anthropic_api_key'] = getpass('enter your anthropic api key: ')

初始化aisuite客户端

创建 aisuite 客户端实例,实现与多个 llm 的标准化交互。

client = ai.client()

defining the prompt

the prompt syntax closely resembles openai’s structure, incorporating roles and content.

messages = [

{"role": "system", "content": "you are a helpful assistant."},

{"role": "user", "content": "tell a joke in 1 line."}

]

查询型号

用户可以使用aisuite查询模型,如下。

# openai model response = client.chat.completions.create(model="openai:gpt-4o", messages=messages, temperature=0.75) # ollama model response = client.chat.completions.create(model="ollama:llama3.1:8b", messages=messages, temperature=0.75) # anthropic model response = client.chat.completions.create(model="anthropic:claude-3-5-sonnet-20241022", messages=messages, temperature=0.75) # groq model response = client.chat.completions.create(model="groq:llama-3.2-3b-preview", messages=messages, temperature=0.75) print(response.choices[0].message.content)

- model="openai:gpt-4o":指定模型的类型和版本。

- messages=messages:将之前定义的提示发送到模型。

- 温度=0.75:调整响应的随机性。较高的值鼓励创造性输出,而较低的值会产生更具确定性的结果。

- response.choices[0].message.content:从模型的响应中检索文本内容。

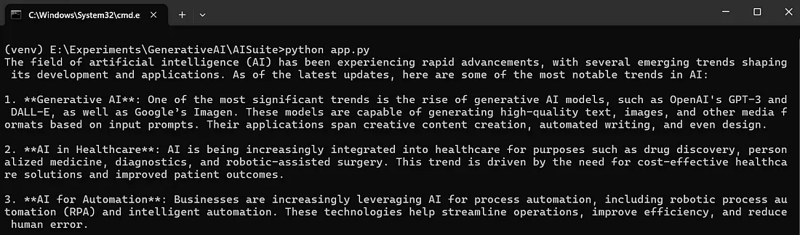

让我们使用 openai 模型创建聊天完成代码。

import os

from dotenv import load_dotenv

load_dotenv()

os.environ['openai_api_key'] = os.getenv('openai_api_key')

import aisuite as ai

client = ai.client()

provider = "openai"

model_id = "gpt-4o"

messages = [

{"role": "system", "content": "you are a helpful assistant"},

{"role": "user", "content": "provide an overview of the latest trends in ai"},

]

response = client.chat.completions.create(

model = f"{provider}:{model_id}",

messages = messages,

)

print(response.choices[0].message.content)

- 使用以下命令运行应用程序。

python app.py

您将得到如下输出,

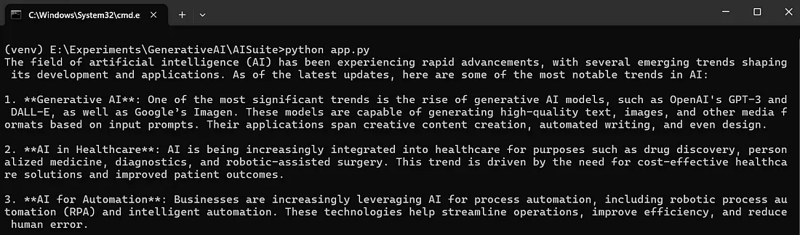

与其编写单独的代码来调用不同的模型,不如创建一个通用函数来消除代码重复并提高效率。

def ask(message, sys_message="you are a helpful assistant", model="openai:gpt-4o"):

client = ai.client()

messages = [

{"role": "system", "content": sys_message},

{"role": "user", "content": message}

]

response = client.chat.completions.create(model=model, messages=messages)

return response.choices[0].message.content

print(ask("provide an overview of the latest trends in ai"))

ask 函数是一个可重用的实用程序,设计用于向 ai 模型发送查询。它接受以下参数:

- 消息:用户的查询或提示。 sys_message(可选):指导模型行为的系统级指令。

- model:指定要使用的ai模型。 该函数处理输入参数,将其发送到指定模型,并返回 ai 的响应,使其成为与各种模型交互的多功能工具。

下面是使用通用询问函数与 openai 模型交互的完整代码。

import os

from dotenv import load_dotenv

load_dotenv()

os.environ['openai_api_key'] = os.getenv('openai_api_key')

import aisuite as ai

def ask(message, sys_message="you are a helpful assistant", model="openai:gpt-4o"):

client = ai.client()

messages = [

{"role": "system", "content": sys_message},

{"role": "user", "content": message}

]

response = client.chat.completions.create(model=model, messages=messages)

return response.choices[0].message.content

print(ask("provide an overview of the latest trends in ai"))

运行代码将产生以下输出。

让我们通过以下代码探索使用 aisuite 与多个模型进行交互。

import os

from dotenv import load_dotenv

load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv('OPENAI_API_KEY')

os.environ['GROQ_API_KEY'] = os.getenv('GROQ_API_KEY')

import aisuite as ai

def ask(message, sys_message="You are a helpful assistant", model="openai:gpt-4o"):

client = ai.Client()

messages = [

{"role": "system", "content": sys_message},

{"role": "user", "content": message}

]

response = client.chat.completions.create(model=model, messages=messages)

return response.choices[0].message.content

print(ask("Who is your creator?"))

print(ask('Who is your creator?', model='ollama:qwen2:1.5b'))

print(ask('Who is your creator?', model='groq:llama-3.1-8b-instant'))

print(ask('Who is your creator?', model='anthropic:claude-3-5-sonnet-20241022'))

与 anthropic 或 groq 等提供商交互时可能会遇到挑战。希望 aisuite 团队正在积极解决这些问题,以确保无缝集成和功能。

aisuite 是一款用于浏览大型语言模型的强大工具。它使用户能够利用多个人工智能提供商的优势,同时简化开发并鼓励创新。凭借其开源基础和直观的设计,aisuite 成为现代人工智能应用程序开发的基石。

感谢您阅读这篇文章!!

感谢 gowri m bhatt 审阅内容。

如果您喜欢这篇文章,请点击心形按钮♥并分享以帮助其他人找到它!

本教程的完整源代码可以在这里找到,

github - codemaker2015/aisuite-examples : github.com

资源github - andrewyng/aisuite:与多个生成式 ai 提供商的简单、统一的接口:github.com

以上就是AISuite:简化跨多个 LLM 提供商的 GenAI 集成的详细内容,更多请关注知识资源分享宝库其它相关文章!

版权声明

本站内容来源于互联网搬运,

仅限用于小范围内传播学习,请在下载后24小时内删除,

如果有侵权内容、不妥之处,请第一时间联系我们删除。敬请谅解!

E-mail:dpw1001@163.com

发表评论